- 欢迎使用超级蜘蛛池(CJZZC)网站外链优化,收藏快捷键 CTRL + D

robots的优化

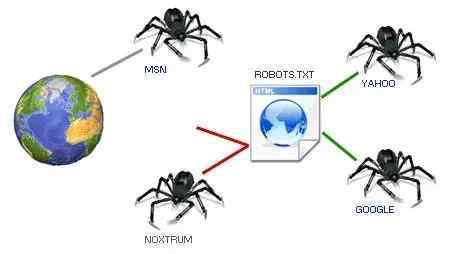

一、robots概述

①robots.txt纯文本文件,网站管理员可以在这里声明该网站不想robots访问的部分,所以robots优化直接影响着搜索引擎对网站的收录情况;

②robots.txt必须放置在一个站点的根目录下,并且文件名必须全部小写:www.cjzzc.com/robots.txt;

③就算你的网站全部内容都可以被搜索引擎收录,那也要写个空的robots.txt;因为有的服务器的设置会使没有robots.txt的时候返回200状态码和相应的错误信息;

二、robots的写法

# robots.txt file from http://www.cjzzc.com/

# All robots will spider the domain

User-agent:*

Disallow:

1、允许搜索引擎访问所有部分(一般可不写)

User-agent:*

Disallow:

2、禁止搜索引擎访问任何部分

User-agent:*

Disallow:/

3、禁止搜索引擎访问某几个部分

User-agent:*

Disallow:http://www.cjzzc.com/404.html

4、允许某个搜索引擎访问

User-agent:Baiduspiter

Disallow:/

5、禁止所有搜索引擎蜘蛛访问某几个目录下的内容及文件

User-agent:*

Disallow:/sss/

Disallow:/aaa/

8、禁止除了百度蜘蛛以外的所有搜索引擎抓取任何内容:

User-agent:Baiduspiter

Disallow:/

User-agent:*

Disallow:/

9、$:通配符,匹配url结尾的字符。禁止百度蜘蛛抓取所有.jpg文件

User-agent:Baiduspiter

Disallow:.jpg$

10、禁止和允许搜索引擎访问某个目录,如:禁止访问admin目录;允许访问images目录。

User-agent:*

Disallow:/admin/

Allow:/images/

11、禁止和允许搜索引擎访问某个后缀,如:禁止访问admin目录下所有php文件;允许访问asp文件。

User-agent:*

Disallow:/admin/*.php$

Allow:/admin/*.asp$

12、禁止索引网站中所有的动态页面(这里限制的是有“?”的域名,如:index.php?id=8)。

User-agent:*

Disallow:/*?*

相关文章推荐

- 2026年谷歌SEO算法环境的核心变化,SEO的制胜之道

- 2025年SEO搜索引擎优化已死吗? Google SEO优化

- 如何人工优化AI智能搜索结果?GEO和SEO的区别?

- 如何使用 JavaScript 和 SerpAPI 构建简单搜索引擎

- 探索网站权重的真实面纱,搜索引擎到底存不存所谓的权重

- 百度百科上线“超级名片”,成了网红们的营销新玩法

- SEO推广就是搜索引擎优化和推广

- SEO搜索引擎优化词库匹配算法

- 解读百度SEO搜索优质内容指南

- 搜索流量与推荐流量的区别联系

- 百度APP移动端搜索悄然下线点赞按钮

- 百度取消百度快照,内容“时效性”进一步加强

- 百度正在暴力截流SEO,企业老板应该怎么做

- 解答百度搜索引擎优化的十五个问题

- 搜狗网站收录页面要诀,搜狗快速收录方法